kubebuilder guide

kubebuilder

kubebuilder 官方文档

https://book.kubebuilder.io/introduction

kubebuilder 可以视为一个软件

go install

装kubebuilder 首先要安装go

https://golang.google.cn/learn/

kubebuilder 应该是只能在linux 中运行的 所以Linux中go 安装好还要配环境变量 当然还要proxy

1 | # go 环境变量 (go 默认是放在 /usr/local下面) |

kubebuilder install

安装 kubebuilder 软件

1 | # download kubebuilder and install locally. |

kubebuilder guide

init

初始化项目

1 | # --domain |

create api

1 | kubebuilder create api --group webapp --version v1 --kind Guestbook |

K8s 为声明式 Api

声明式即 我只需要提交一个定义好的API对象来说明 “声明” (即yaml文件) 表示所期望的最终状态是什么样子就可以了 而如果提交的是一个个命令去指导怎么一步一步达到期望状态 这就是命令式”Api”

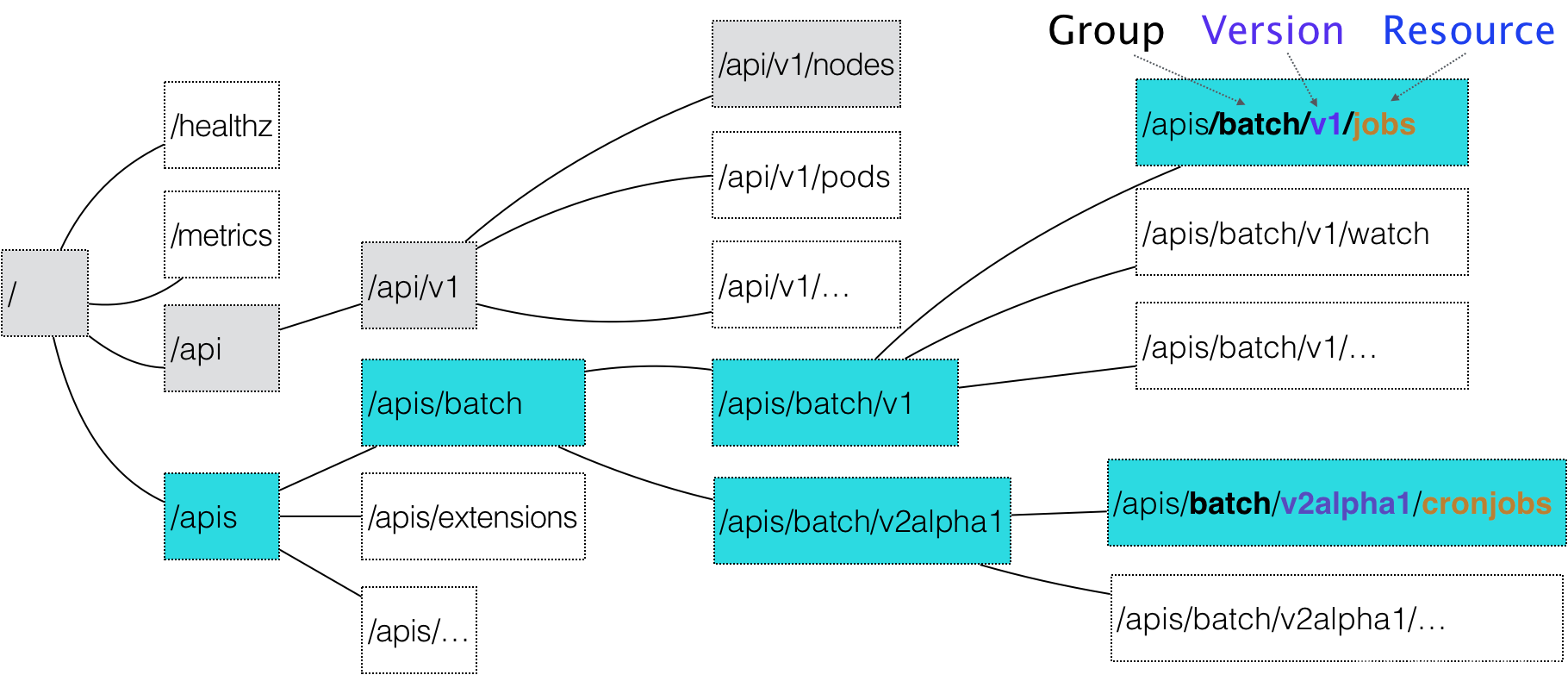

由上图可知 group + version + resource 可确定一组api资源 因此对于我们自己的创建的api 要指定 group version resource类型即kind

k8s 所定义的API对象都是 声明式API

声明式API 并不像命令式API 那样有着明显的执行逻辑 声明式一个所声明的状态 这就使得基于声明式API的业务功能实现 往往需要通过controller 来监控 API的对象的变化以此来决定实际要执行的工作

因此执行完 上述 kubebuilder create api 命令后 除了会在 api/v1 下生成 关于资源定义的文件 groupversion_info.go\ guestbook_types.go 后还会在 internal/controller 下生成 crd资源的 controller文件

在controller文件中就可以实现对于 crd资源的业务操作

controller 的执行逻辑如下 涉及K8s 具体的底层原理机制

核心是一个 reconcile 调谐的过程 即不断当前crd的资源 调整成和 期望状态

controller其实可以分为2部分来看:左边的 Informer,右面的 control loop,中间通过一个workqueue来进行协同。

workqueue

K8s workqueue 的workqueue 是一个fifo 队列 基于fifo 的基础上可以实现 延迟队列、限速队列 支持顺序、去重、并发等

Informer 主要用来与APIServer 进行数据同步。就是一个自带缓存和索引机制,可以触发 Handler 的客户端库。

这个本地缓存在 Kubernetes 中一般被称为 Store,索引一般被称为 Index。Informer 使用了 Reflector 包,它是一个可以通过 ListAndWatch 机制获取并监视 API 对象变化的客户端封装。Reflector 和 Informer 之间,用到了一个“增量先进先出队列”进行协同。

list-watch

https://zhuanlan.zhihu.com/p/59660536

list-watch 是一个异步消息系统 对于消息机制要实现 以下四点要求:

消息可靠性

消息实时性

消息顺序性

高性能

list-watch 机制核心是通过 resourceVersion实现 wath机制 采用http长链接(更具体的是 采用了 Chunked transfer encoding)

list和watch一起保证了消息的可靠性,避免因消息丢失而造成状态不一致场景。具体而言,list API可以查询当前的资源及其对应的状态(即期望的状态),客户端通过拿期望的状态和实际的状态进行对比,纠正状态不一致的资源。Watch API和apiserver保持一个长链接,接收资源的状态变更事件并做相应处理。如果仅调用watch API,若某个时间点连接中断,就有可能导致消息丢失,所以需要通过list API解决消息丢失的问题。从另一个角度出发,可以认为list API获取全量数据,watch API获取增量数据。虽然仅仅通过轮询list API,也能达到同步资源状态的效果,但是存在开销大,实时性不足的问题。

消息必须是实时的,list-watch机制下,每当apiserver的资源产生状态变更事件,都会将事件及时的推送给客户端,从而保证了消息的实时性。

消息的顺序性也是非常重要的,在并发的场景下,客户端在短时间内可能会收到同一个资源的多个事件,对于关注最终一致性的K8S来说,它需要知道哪个是最近发生的事件,并保证资源的最终状态如同最近事件所表述的状态一样。K8S在每个资源的事件中都带一个resourceVersion的标签,这个标签是递增的数字,所以当客户端并发处理同一个资源的事件时,它就可以对比resourceVersion来保证最终的状态和最新的事件所期望的状态保持一致。

List-watch还具有高性能的特点,虽然仅通过周期性调用list API也能达到资源最终一致性的效果,但是周期性频繁的轮询大大的增大了开销,增加apiserver的压力。而watch作为异步消息通知机制,复用一条长链接,保证实时性的同时也保证了性能。

control loop

control loop 是 while true 循环 , 从workqueue从那里 不断拿event

每一个循环周期执行的正是我们真正关心的业务逻辑,通过对比“期望状态”和“实际状态”的差异,不断进行Reconcile

kubebuilder project dir

生成了 api 整个 kubebuilder project的目录 大致如下所示

1 | └── guestbook |

types.go

crd的核心属性 基本与 实际K8s中crd资源的属性是一一对应的

1 | package v1 |

每次 修改完 types中的属性 都要在make 一下

然后属性就会更新到 crd/base 下面的具体crd 文件里面 根据这个文件 即可 通过 Kubectl 命令 更新实际K8s集群中的文件